El hecho de que hayan existido búsquedas en Internet sobre el tipo de ropa que utiliza la reina Letizia Ortiz ha configurado automáticamente que el Chat GPT, reconocida herramienta de inteligencia artificial generativa, priorice este tipo de información cada vez que se le consulte algún dato sobre la reina consorte de España.

Por otra parte, un estudio de la Universidad de Washington determinó que en los primeros 10 resultados de las búsquedas de imágenes que se hacen en Google sobre el término “CEO”, apenas un 11% corresponden a fotos de mujeres.

Estos son apenas dos ejemplos de cómo la Internet se ha convertido también en un espacio donde los prejuicios y las estigmatizaciones en contra de las mujeres han reproducido lo que tradicionalmente ocurre en el mundo real.

El tema se abordó durante la conferencia Cómo impedir el sexismo en la IA, a cargo del Instituto de Estudios de la Mujer (IEM) de la Facultad de Filosofía y Letras de la Universidad Nacional (UNA). La exposición estuvo a cargo de la académica Tasia Aránguez Sánchez, de la Unidad de Excelencia de la Sociedad Digital, de la Universidad de Granada, España.

“Los sesgos sexistas en la inteligencia artificial son producto de las personas que programan los algoritmos sobre los cuales funcionan los sistemas. Y esto es producto de una sociedad que ha alimentado estos patrones que afectan a las mujeres”, detallo la experta.

Desde la unidad para la cual labora, la profesora de Filosofía del Derecho de la Universidad de Granada desmenuzó los diferentes tipos de sesgos sexistas que se han reproducido en los algoritmos de programación.

Uno de los más comunes es el de la reproducción de la discriminación que existe en los datos, tal y como ocurre con el caso de la búsqueda de imágenes de CEO en Google. Sin embargo, ocurre también que desde el lenguaje de programación se ha asumido que el hombre es el sujeto universal. “Existen aplicaciones informativas que no hacen ningún tipo de diferenciación entre los sexos y patentizan el lenguaje masculino, replicando los errores que a lo largo de la historia hemos visto”, enfatizó Aránguez.

En la programación de algoritmos se han dado casos de “variables correlativas” que dan lugar a discriminaciones que pueden tener una afectación directa contra las mujeres. Eso ocurre, por ejemplo, cuando la tarjeta bancaria de una empresa global de teléfonos móviles otorgaba hasta 10 veces más de crédito al hombre que a la mujer de una pareja con la misma renta.

Si desde la programación algorítmica se promueven estos sesgos tan marcados, existe el riesgo comprobado de que se pueda alimentar el sexismo entre las personas usuarias de la tecnología.

Esto ocurre, según un análisis de la investigadora Lucía Aragüez, de la Universidad de Málaga, por ejemplo, con el caso de una plataforma digital de transporte, la cual permitía a los usuarios anular el viaje sabiendo quién era la persona conductora. De esta manera se identificó que las mujeres recibían menos peticiones de viajes, con un impacto relevante en el salario que percibían.

Cosificación y automatismos

La baja participación de las mujeres en funciones de programación tiene una implicación directa en la prevalencia de estos sesgos. De acuerdo con un dato aportado por Tasia Aránguez, únicamente un 15% de las personas que escriben en Wikipedia son mujeres.

Esto explicaría en gran medida la valoración cosificada y sexista que se presenta, por ejemplo, en la programación de videojuegos, un campo de alta atracción, sobre todo en personas jóvenes, donde se presentan personajes femeninos o robots con alto componente sexualizado.

El automatismo se presenta debido a que la IA carece de la flexibilidad humana y del sentido común para interpretar ciertos aspectos no previstos. Esto ocurre cuando, por ejemplo, una mujer ha tenido que dejar de trabajar por asumir la labor de cuido de un familiar y en su hoja de vida se genera un espacio incompleto en su experiencia laboral. Este detalle puntual, puede no ser reconocido por un algoritmo y beneficiar en este caso a otra persona que no ha tenido que asumir esa responsabilidad familiar.

¿Qué se puede hacer?

Para Tasia Aránguez, es fundamental que desde las propias empresas creadoras e impulsoras de la inteligencia artificial existan mecanismos de autorregulación que permitan garantizar la ética tecnológica con perspectiva de género.

Otra vía que despeja el camino a la subjetividad o al criterio empresarial va por el lado de la reglamentación y las leyes. En este apartado, destacan los esfuerzos emprendidos por la Unión Europea, bloque que aprobó el año anterior una ley sobre inteligencia artificial que regula el uso de esta tecnología en función del riesgo que representa para las personas.

Entre otros aspectos, esta regulación establece la necesidad de prever la supervisión humana sobre los sistemas, asegurar la protección de la autonomía, la privacidad de los datos y promover la igualdad y el aseguramiento de los derechos humanos.

En Costa Rica se presentó el 30 de mayo de 2023 el proyecto 23.771 Ley de Regulación de la Inteligencia Artificial que tuvo la particularidad de que fue creado por la herramienta Chat GPT. La iniciativa ha enfrentado críticas de diversos sectores por su formulación y se encuentra en trámite en la Comisión Especial de Ciencia, Tecnología y Educación.

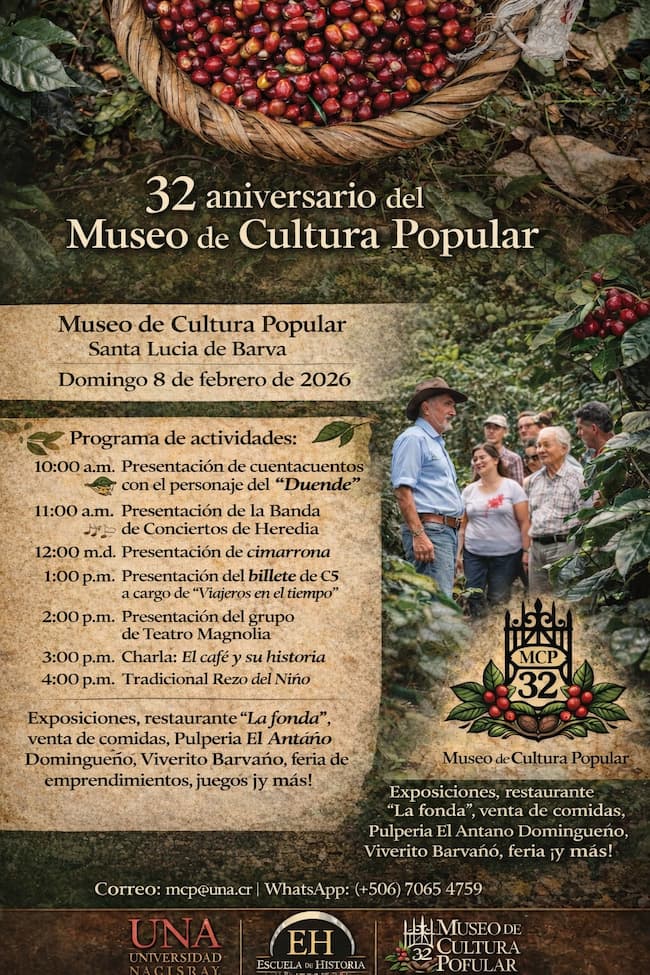

Foto: pikisuperstar/ Freepik.es